Le fait que les organisations soient confrontées aux défis du Big Data est courant de nos jours. Le terme Big Data fait référence à l'utilisation d'un ensemble de technologies multiples, anciennes et nouvelles, pour extraire des informations significatives d'une énorme pile de données. L'ensemble de données est non seulement volumineux, mais présente également son propre ensemble unique de défis pour les capturer, les gérer et les traiter. Contrairement aux données persistantes dans les bases de données relationnelles, qui sont structurées, le format Big Data peut être structuré, semi-structuré à non structuré, ou collecté à partir de différentes sources avec des tailles différentes. Cet article se penche sur les aspects fondamentaux du Big Data, ses caractéristiques de base, et vous donne un aperçu des outils et techniques utilisés pour y faire face.

Un aperçu

Le terme Big Data donne une impression uniquement de la taille des données. C'est vrai dans un sens, mais cela ne donne pas une vue d'ensemble. Les défis qui lui sont associés ne concernent pas seulement sa taille. En fait, l'idée a évolué pour nommer une mer de données collectées à partir de diverses sources, formats et tailles, et, en même temps, difficiles à exploiter ou à en tirer de la valeur. L'essor des technologies émergentes et l'utilisation croissante d'Internet ont donné une impulsion au volume et à la disparité. Le volume ne cesse d'augmenter avec chaque échange d'informations sur Internet ou même les minuscules objets IoT que nous utilisons. Le simple fait de décrocher un appel téléphonique ou d'allumer la CCTV peut générer une chaîne de données. Aujourd'hui, la plupart des appareils sont connectés en ligne. Désormais, si une organisation souhaite collecter ces informations en ligne, elle a besoin d'un processus de traitement spécial car les données générées seront massives. De plus, il se peut qu'il n'y ait pas d'uniformité dans le format des données saisies. Cela ajoute à la complexité car nous devons traiter des données structurées, semi-structurées ou non structurées. Les outils que nous utilisions jusqu'à présent pour organiser les données sont incapables de traiter une telle variété et un tel volume. Par conséquent, nous pouvons dire que le terme Big Data s'applique en fait aux données qui ne peuvent pas être traitées ou analysées via les outils et techniques traditionnels qui sont normalement utilisés pour traiter des données structurées ou semi-structurées telles que l'utilisation de bases de données relationnelles, XML, etc.

Aujourd'hui, les organisations regorgent de données non structurées ou semi-structurées disponibles au format brut. Ces données peuvent être une mine d'informations si elles sont traitées et la valeur qui en est tirée. Mais, le problème est de savoir comment le faire. Les techniques et outils traditionnels, tels que les bases de données relationnelles, sont inadéquats pour traiter un volume aussi important de données variées. C'est aussi un problème à double tranchant pour les organisations, car le simple fait de les déchiqueter signifierait perdre des informations précieuses - le cas échéant - et les conserver est un gaspillage de ressources. Par conséquent, certains outils et techniques sont recherchés pour résoudre le problème. Parfois, nous sommes tout à fait sûrs de sa valeur potentielle dans la pile et pouvons récolter une mine d'or d'informations mais, sans outils appropriés, il est assez difficile pour le processus métier d'en tirer le moindre avantage. Les données d'aujourd'hui sont massives et ont explosé comme tout ces dernières années; au fait, il semble impossible de l'arrêter.

Explosion d'informations

Le Big Data s'agrandit à chaque minute dans presque tous les secteurs, qu'il s'agisse de la technologie, des médias, de la vente au détail, des services financiers, des voyages et des médias sociaux, pour n'en nommer que quelques-uns. Le volume de traitement de données dont nous parlons est ahurissant. Voici quelques informations statistiques pour vous donner une idée :

- Les canaux météo reçoivent 18 055 555 demandes de prévisions chaque minute.

- Les utilisateurs de Netflix diffusent 97 222 heures de vidéo chaque minute.

- Les utilisateurs de Skype passent 176 220 appels par minute.

- Les utilisateurs d'Instagram publient 49 380 photos par minute.

Ces chiffres augmentent chaque année, avec un nombre croissant de personnes utilisant Internet. En 2017, l'utilisation d'Internet a atteint jusqu'à 47 % (3,8 milliards de personnes) de la population mondiale. Avec un nombre sans cesse croissant d'appareils électroniques, nos données de sortie approximatives sont estimées à 2,5 quintillions d'octets par jour et ne cessent d'augmenter.

Les statistiques de Google Search montrent 3,5 milliards de recherches par jour, soit plus de 40 000 recherches par seconde en moyenne. Nous ne devons pas non plus manquer que d'autres moteurs de recherche effectuent également des recherches. Le rapport sur les statistiques de messagerie, 2015-2019 de Radicati Group, Inc., indique 2,9 milliards d'utilisateurs de messagerie d'ici 2019.

Pour tenter d'estimer le nombre de photos qui seront prises en 2017 :s'il y avait 7,5 milliards de personnes dans le monde en 2017, dont environ 5 milliards avaient des téléphones portables, une estimation probable est que 80 % de ces téléphones ont des appareils photo intégrés. Cela signifie qu'il y a environ 4 milliards de personnes qui utilisent leurs caméras. S'ils prennent 10 photos par jour, soit 3 650 photos par an et par personne, cela représente environ 14 000 milliards de photos prises par an.

Par conséquent, lorsque nous disons Big Data, cela fait essentiellement référence à des données ou à des ensembles d'enregistrements qui sont trop volumineux pour être conjecturables. Ils sont produits par les moteurs de recherche, l'informatique commerciale, les réseaux sociaux, les médias sociaux, la génomique, la météorologie, les prévisions météorologiques et de nombreuses autres sources. Cela ne peut évidemment pas être opéré en utilisant les outils et techniques de gestion de base de données existants. Le Big Data ouvre une arène de grands défis en termes de stockage, de capture, de gestion, de maintenance, d'analyse, de recherche, de nouveaux outils pour les gérer, etc.

Caractéristiques des mégadonnées

Comme pour toutes les grandes choses, si nous voulons les gérer, nous devons les caractériser pour organiser notre compréhension. Par conséquent, le Big Data peut être défini par une ou plusieurs des trois caractéristiques, les trois V :un volume élevé , haute variété , et une vitesse élevée . Ces caractéristiques soulèvent des questions importantes qui non seulement nous aident à les déchiffrer, mais donnent également un aperçu de la façon de traiter des données massives et disparates à une vitesse gérable dans un délai raisonnable afin que nous puissions en tirer de la valeur, faire quelques analyse en temps réel et fournir une réponse ultérieure rapidement.

- Volume : Le volume fait référence à la taille même des données en constante explosion du monde informatique. Cela soulève la question de la quantité de données.

- Vitesse : La vitesse fait référence à la vitesse de traitement. Cela soulève la question de la vitesse à laquelle les données sont traitées.

- Variété : La variété fait référence aux types de données. Cela soulève la question de la disparité des formats de données.

Notez que nous caractérisons le Big Data en trois V, uniquement pour simplifier ses principes de base. Il est tout à fait possible que la taille soit relativement petite, mais trop variée et complexe, ou qu'elle puisse être relativement simple mais un énorme volume de données. Par conséquent, en plus de ces trois V, nous pouvons facilement en ajouter un autre, Véracité . La véracité détermine l'exactitude des données par rapport à la valeur commerciale que nous voulons extraire. Sans véracité, il est impossible pour une organisation d'appliquer ses ressources pour analyser la pile de données. Avec plus de précision quant au contexte des données, il y a plus de chances d'obtenir des informations précieuses. Par conséquent, la véracité est une autre caractéristique du Big Data. Les entreprises exploitent les données structurées, semi-structurées et non structurées des e-mails, des réseaux sociaux, des flux de texte, etc. Mais, avant l'analyse, il est important d'identifier la quantité et les types de données à prendre en considération qui auraient un impact sur les résultats commerciaux.

Outils et techniques

L'intelligence artificielle (IA), l'IdO et les médias sociaux augmentent la complexité des données à travers de nouvelles formes et sources. Par exemple, il est crucial qu'en temps réel, les mégadonnées provenant de capteurs, d'appareils, de réseaux, de transactions soient capturées, gérées et traitées avec une faible latence. Le Big Data permet aux analystes, aux chercheurs et aux utilisateurs professionnels de prendre plus rapidement des décisions plus éclairées, en utilisant des données historiques qui seraient autrement inaccessibles. On peut utiliser l'analyse de texte, l'apprentissage automatique, l'analyse prédictive, l'exploration de données et le traitement du langage naturel pour extraire de nouvelles informations de la pile de données disponibles.

La technologie a évolué pour gérer des volumes massifs de données, qui étaient auparavant coûteux et devaient s'appuyer sur des supercalculateurs. Avec l'émergence des médias sociaux comme Facebook, des moteurs de recherche comme Google et Yahoo!, les projets Big Data ont pris de l'ampleur et se sont développés comme aujourd'hui. Des technologies telles que MapReduce, Hadoop et Big Table ont été développées pour répondre aux besoins actuels.

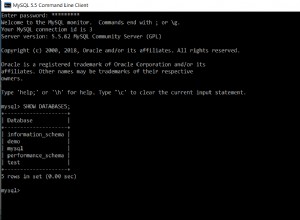

Les référentiels NoSQL sont également évoqués en relation avec le Big Data. C'est une base de données alternative contrairement aux bases de données relationnelles. Ces bases de données n'organisent pas les enregistrements dans des tableaux de lignes et de colonnes comme on en trouve dans les bases de données relationnelles conventionnelles. Il existe différents types de bases de données NoSQL, telles que Content Store, Document Store, Event Store, Graph, Key Value, etc. Ils n'utilisent pas SQL pour les requêtes et suivent un modèle architectural différent. Ils sont trouvés pour faciliter Big Data Analytics d'une manière favorable. Certains noms populaires sont :Hbase, MongoDB, CouchDB et Neo4j. En dehors d'eux, il y en a beaucoup d'autres.

Conclusion

Le Big Data a ouvert une nouvelle opportunité de récolter des données et d'en extraire de la valeur, ce qui, autrement, était un gâchis. Il est impossible de capturer, gérer et traiter le Big Data à l'aide d'outils traditionnels tels que les bases de données relationnelles. La plate-forme Big Data fournit les outils et les ressources nécessaires pour extraire des informations sur les données volumineuses, variées et rapides. Ces piles de données disposent désormais de moyens et d'un contexte viable pour être utilisées à diverses fins dans le processus métier d'une organisation. Par conséquent, pour identifier exactement de quel type de données nous parlons, nous devons d'abord les comprendre ainsi que leurs caractéristiques.