Il y a donc quelques points à aborder ici.

La docs sur PyMySQL sont assez doués pour vous aider à démarrer.

Avant de pouvoir mettre ces éléments dans une base de données, vous devez les saisir de manière à ce que l'artiste et le nom de la chanson soient associés l'un à l'autre. À l'heure actuelle, vous obtenez une liste distincte d'artistes et de chansons, sans aucun moyen de les associer. Vous voudrez itérer sur la classe title-artist pour ce faire.

Je ferais ça comme ça -

from urllib import urlopen

from bs4 import BeautifulSoup

import pymysql.cursors

# Webpage connection

html = urlopen("http://www.officialcharts.com/charts/singles-chart/19800203/7501/")

# Grab title-artist classes and iterate

bsObj = BeautifulSoup(html)

recordList = bsObj.findAll("div", {"class" : "title-artist",})

# Now iterate over recordList to grab title and artist

for record in recordList:

title = record.find("div", {"class": "title",}).get_text().strip()

artist = record.find("div", {"class": "artist"}).get_text().strip()

print artist + ': ' + title

Cela imprimera le titre et l'artiste pour chaque itération de la boucle recordList.

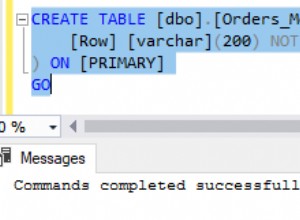

Pour insérer ces valeurs dans une base de données MySQL, j'ai créé une table appelée artist_song avec ce qui suit :

CREATE TABLE `artist_song` (

`id` int(11) NOT NULL AUTO_INCREMENT,

`artist` varchar(255) COLLATE utf8_bin NOT NULL,

`song` varchar(255) COLLATE utf8_bin NOT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin

AUTO_INCREMENT=1;

Ce n'est pas la façon la plus propre de s'y prendre, mais l'idée est bonne. On veut ouvrir une connexion à la BD MySQL (j'ai appelé ma BD top_40), et insérer un couple artiste/titre pour chaque itération de la boucle recordList :

from urllib import urlopen

from bs4 import BeautifulSoup

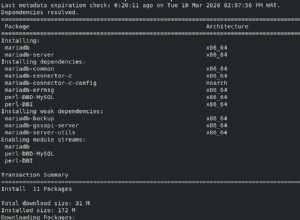

import pymysql.cursors

# Webpage connection

html = urlopen("http://www.officialcharts.com/charts/singles-chart/19800203/7501/")

# Grab title-artist classes and store in recordList

bsObj = BeautifulSoup(html)

recordList = bsObj.findAll("div", {"class" : "title-artist",})

# Create a pymysql cursor and iterate over each title-artist record.

# This will create an INSERT statement for each artist/pair, then commit

# the transaction after reaching the end of the list. pymysql does not

# have autocommit enabled by default. After committing it will close

# the database connection.

# Create database connection

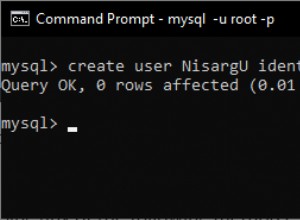

connection = pymysql.connect(host='localhost',

user='root',

password='password',

db='top_40',

charset='utf8mb4',

cursorclass=pymysql.cursors.DictCursor)

try:

with connection.cursor() as cursor:

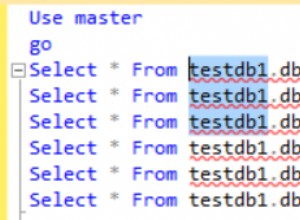

for record in recordList:

title = record.find("div", {"class": "title",}).get_text().strip()

artist = record.find("div", {"class": "artist"}).get_text().strip()

sql = "INSERT INTO `artist_song` (`artist`, `song`) VALUES (%s, %s)"

cursor.execute(sql, (artist, title))

connection.commit()

finally:

connection.close()

Edit :Selon mon commentaire, je pense qu'il est plus clair de parcourir les lignes du tableau à la place :

from urllib import urlopen

from bs4 import BeautifulSoup

import pymysql.cursors

# Webpage connection

html = urlopen("http://www.officialcharts.com/charts/singles-chart/19800203/7501/")

bsObj = BeautifulSoup(html)

rows = bsObj.findAll('tr')

for row in rows:

if row.find('span', {'class' : 'position'}):

position = row.find('span', {'class' : 'position'}).get_text().strip()

artist = row.find('div', {'class' : 'artist'}).get_text().strip()

track = row.find('div', {'class' : 'title'}).get_text().strip()