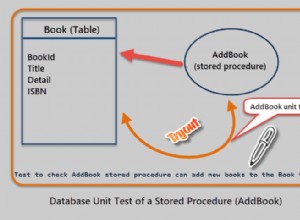

Vous pouvez le faire en un seul appel de php vers mysql si vous utilisez une procédure stockée :

Exemples d'appels

mysql> call category_hier(1);

+--------+---------------+---------------+----------------------+-------+

| cat_id | category_name | parent_cat_id | parent_category_name | depth |

+--------+---------------+---------------+----------------------+-------+

| 1 | Location | NULL | NULL | 0 |

| 3 | USA | 1 | Location | 1 |

| 4 | Illinois | 3 | USA | 2 |

| 5 | Chicago | 3 | USA | 2 |

+--------+---------------+---------------+----------------------+-------+

4 rows in set (0.00 sec)

$sql = sprintf("call category_hier(%d)", $id);

J'espère que cela vous aidera :)

Scénario complet

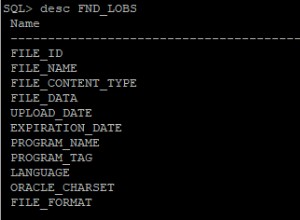

Structure du tableau de test :

drop table if exists categories;

create table categories

(

cat_id smallint unsigned not null auto_increment primary key,

name varchar(255) not null,

parent_cat_id smallint unsigned null,

key (parent_cat_id)

)

engine = innodb;

Données de test :

insert into categories (name, parent_cat_id) values

('Location',null),

('USA',1),

('Illinois',2),

('Chicago',2),

('Color',null),

('Black',3),

('Red',3);

Procédure :

drop procedure if exists category_hier;

delimiter #

create procedure category_hier

(

in p_cat_id smallint unsigned

)

begin

declare v_done tinyint unsigned default 0;

declare v_depth smallint unsigned default 0;

create temporary table hier(

parent_cat_id smallint unsigned,

cat_id smallint unsigned,

depth smallint unsigned default 0

)engine = memory;

insert into hier select parent_cat_id, cat_id, v_depth from categories where cat_id = p_cat_id;

/* http://dev.mysql.com/doc/refman/5.0/en/temporary-table-problems.html */

create temporary table tmp engine=memory select * from hier;

while not v_done do

if exists( select 1 from categories p inner join hier on p.parent_cat_id = hier.cat_id and hier.depth = v_depth) then

insert into hier

select p.parent_cat_id, p.cat_id, v_depth + 1 from categories p

inner join tmp on p.parent_cat_id = tmp.cat_id and tmp.depth = v_depth;

set v_depth = v_depth + 1;

truncate table tmp;

insert into tmp select * from hier where depth = v_depth;

else

set v_done = 1;

end if;

end while;

select

p.cat_id,

p.name as category_name,

b.cat_id as parent_cat_id,

b.name as parent_category_name,

hier.depth

from

hier

inner join categories p on hier.cat_id = p.cat_id

left outer join categories b on hier.parent_cat_id = b.cat_id

order by

hier.depth, hier.cat_id;

drop temporary table if exists hier;

drop temporary table if exists tmp;

end #

Tests exécutés :

delimiter ;

call category_hier(1);

call category_hier(2);

Certains tests de performances utilisant les données Yahoo geoplanet places

drop table if exists geoplanet_places;

create table geoplanet_places

(

woe_id int unsigned not null,

iso_code varchar(3) not null,

name varchar(255) not null,

lang varchar(8) not null,

place_type varchar(32) not null,

parent_woe_id int unsigned not null,

primary key (woe_id),

key (parent_woe_id)

)

engine=innodb;

mysql> select count(*) from geoplanet_places;

+----------+

| count(*) |

+----------+

| 5653967 |

+----------+

cela fait donc 5,6 millions de lignes (places) dans le tableau. Voyons comment l'implémentation de la liste de contiguïté/procédure stockée appelée depuis php gère cela.

1 records fetched with max depth 0 in 0.001921 secs

250 records fetched with max depth 1 in 0.004883 secs

515 records fetched with max depth 1 in 0.006552 secs

822 records fetched with max depth 1 in 0.009568 secs

918 records fetched with max depth 1 in 0.009689 secs

1346 records fetched with max depth 1 in 0.040453 secs

5901 records fetched with max depth 2 in 0.219246 secs

6817 records fetched with max depth 1 in 0.152841 secs

8621 records fetched with max depth 3 in 0.096665 secs

18098 records fetched with max depth 3 in 0.580223 secs

238007 records fetched with max depth 4 in 2.003213 secs

Dans l'ensemble, je suis assez satisfait de ces temps d'exécution froids, car je ne commencerais même pas à envisager de renvoyer des dizaines de milliers de lignes de données à mon frontal, mais je préférerais construire l'arborescence de manière dynamique en ne récupérant que plusieurs niveaux par appel. Oh et juste au cas où vous pensiez qu'innodb est plus lent que myisam - l'implémentation de myisam que j'ai testée était deux fois plus lente dans tous les cas.

Plus de choses ici :http://pastie.org/1672733

J'espère que cela vous aidera :)