La transformation numérique est un sujet brûlant pour tous les marchés et toutes les industries, car elle apporte de la valeur avec des taux de croissance explosifs. Considérez que l'Internet des objets de l'industrie manufacturière (IIOT) était évalué à 161 milliards de dollars avec un taux de croissance impressionnant de 25 %, le marché de la voiture connectée sera évalué à 225 milliards de dollars d'ici 2027 avec un taux de croissance de 17 %, ou qu'au cours des trois premiers mois de 2020, les détaillants ont réalisé dix ans de pénétration des ventes numériques en seulement trois mois. Cependant, la plupart de ce qui est écrit concerne les plates-formes technologiques habilitantes (solutions cloud ou de périphérie ou ponctuelles telles que les entrepôts de données) ou les cas d'utilisation qui génèrent ces avantages (analyse prédictive appliquée à la maintenance préventive, détection des fraudes par les institutions financières ou surveillance prédictive de la santé comme exemples) et non les données sous-jacentes. Le chapitre manquant ne concerne pas les solutions ponctuelles ou le parcours de maturité des cas d'utilisation. Le chapitre manquant concerne les données - il s'agit toujours des données - et, plus important encore, les données de parcours se tissent de la périphérie à l'intelligence artificielle.

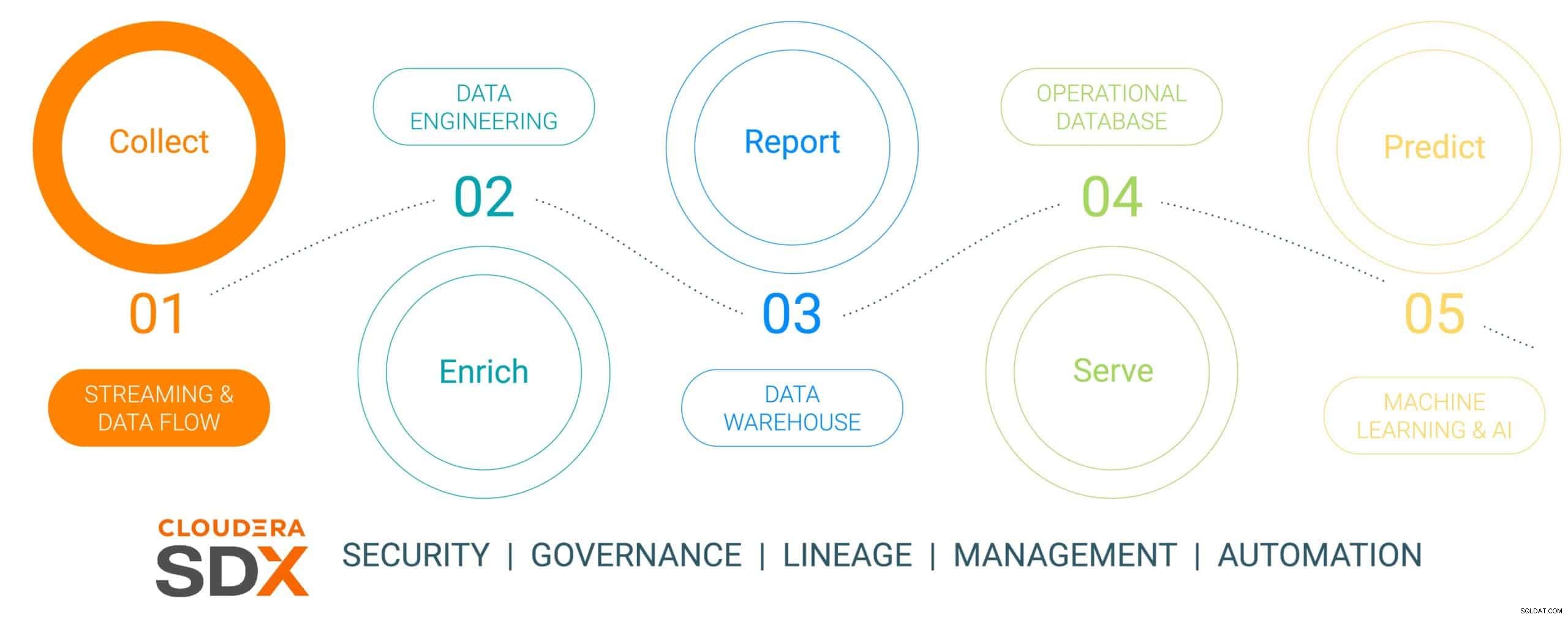

Il s'agit du premier d'une série de blogs en six parties qui décrit le parcours des données de la périphérie à l'IA et la valeur commerciale que les données produisent tout au long du parcours. Le parcours des données n'est pas linéaire, mais il s'agit d'un cycle de vie des données en boucle infinie - commençant à la périphérie, se faufilant à travers une plate-forme de données et aboutissant à des informations sur les impératifs commerciaux appliqués à de vrais problèmes critiques qui se traduisent par de nouvelles initiatives axées sur les données. Nous avons simplifié ce parcours en cinq étapes distinctes avec une sixième étape commune concernant la sécurité et la gouvernance des données. Les six étapes sont :

- Collecte de données – ingestion et surveillance des données à la périphérie (qu'il s'agisse de capteurs industriels ou de personnes dans un magasin physique)

- Enrichissement des données - traitement, agrégation et gestion du pipeline de données pour préparer les données pour un raffinement ultérieur

- Rapports – fournir des informations sur l'entreprise (analyse et prévision des ventes, étude de marché, budgétisation, par exemple)

- Servir – contrôler et exécuter les opérations commerciales essentielles (transactions aux distributeurs automatiques de billets, caisses de vente au détail ou surveillance de la production)

- Analyse prédictive – analyse prédictive basée sur l'IA et l'apprentissage automatique (détection des fraudes, maintenance prédictive, optimisation des stocks basée sur la demande, par exemple)

- Sécurité et gouvernance – un ensemble intégré de technologies de sécurité, de gestion et de gouvernance sur l'ensemble du cycle de vie des données

Fig 1 :Le cycle de vie des données d'entreprise

Pour illustrer le parcours des données, nous avons choisi un sujet de fabrication très pertinent et soucieux du développement durable - la fabrication d'une voiture électrique, choisie parce que les opérations de fabrication sont généralement de nature révolutionnaire (haute maturité numérique déployant les outils de données les plus récents) , par rapport à «l'évolution de la vieille école» (de maturité inférieure) et que la plupart de ces voitures sont construites en tant que plates-formes de mobilité connectée, faisant de la voiture plus qu'un simple moyen de transport, mais une plate-forme de connaissances et d'informations basées sur les données. Cette histoire montrera comment les données sont collectées, enrichies, stockées, servies, puis utilisées pour prédire les événements du processus de fabrication de la voiture à l'aide de Cloudera Data Platform.

Cette histoire mettra en vedette une fausse entreprise de fabrication de véhicules connectés appelée (avec un nom très original) The Electric Car Company (ECC). ECC exploite plusieurs usines de fabrication situées à travers le monde, est intégrée verticalement et construit ses propres voitures ainsi que de nombreux composants critiques, notamment les moteurs électriques, les batteries et les pièces auxiliaires. Chaque usine est chargée de fabriquer différents composants, l'assemblage final ayant lieu dans quelques usines sélectionnées et stratégiquement situées.

Défi de collecte de données

La gestion de la collecte de toutes les données de toutes les usines du processus de fabrication est une entreprise importante qui présente quelques défis :

- Difficulté à évaluer le volume et la variété des données IoT : De nombreuses usines utilisent à la fois des actifs et des appareils de fabrication modernes et hérités de plusieurs fournisseurs, avec divers protocoles et formats de données. Bien que les contrôleurs et les appareils puissent être connectés à un système OT, ils ne sont généralement pas connectés de manière à pouvoir partager facilement les données avec les systèmes informatiques. Afin de permettre la fabrication connectée et les cas d'utilisation émergents de l'IoT, ECC a besoin d'une solution capable de gérer tous les types de structures et de schémas de données divers depuis la périphérie, de normaliser les données, puis de les partager avec tout type de consommateur de données, y compris les applications Big Data.

- Gérer la complexité des données en temps réel : Pour qu'ECC puisse générer des cas d'utilisation d'analyse prédictive, une plate-forme de gestion des données doit permettre l'analyse en temps réel des données en continu. La plate-forme doit également ingérer, stocker et traiter efficacement les données de streaming en temps réel ou quasi réel afin de fournir instantanément des informations et des actions.

- Libérer les données des silos indépendants : Les processus spécialisés (plateformes d'innovation, SMQ, MES, etc.) au sein de la chaîne de valeur de fabrication récompensent des sources de données et des plateformes de gestion de données disparates qui s'adaptent à des solutions cloisonnées uniques. Ces solutions de niche limitent la valeur de l'entreprise, ne considérant qu'une fraction des informations que les données inter-entreprises peuvent offrir, tout en divisant l'activité et en limitant les opportunités de collaboration. La bonne plate-forme doit avoir la capacité d'ingérer, de stocker, de gérer, d'analyser et de traiter des données en continu à partir de tous les points de la chaîne de valeur, de les combiner avec des sources d'historique de données, d'ERP, de MES et de QMS, et de les exploiter en informations exploitables. Ces informations fourniront des tableaux de bord, des rapports et des analyses prédictives qui génèrent des cas d'utilisation de fabrication à haute valeur ajoutée.

- Équilibrer le bord : Comprendre le juste équilibre entre le traitement des données à la périphérie et dans le cloud est un défi, et c'est pourquoi l'ensemble du cycle de vie des données doit être pris en compte. Il y a une tendance troublante dans l'industrie alors que les entreprises choisissent de se concentrer sur l'un ou l'autre sans se rendre compte qu'elles peuvent et doivent faire les deux. Le cloud computing a ses avantages pour l'analyse à long terme et le déploiement à grande échelle, mais il est limité par la bande passante et collecte souvent de grandes quantités de données tout en n'en utilisant qu'une petite partie. La valeur de la périphérie réside dans le fait qu'elle agit à la périphérie, là où elle a le plus d'impact, sans aucune latence, avant d'envoyer les données les plus précieuses au cloud pour un traitement plus performant.

Collecte de données à l'aide de la plate-forme de données Cloudera

ÉTAPE 1 :Collecter les données brutes

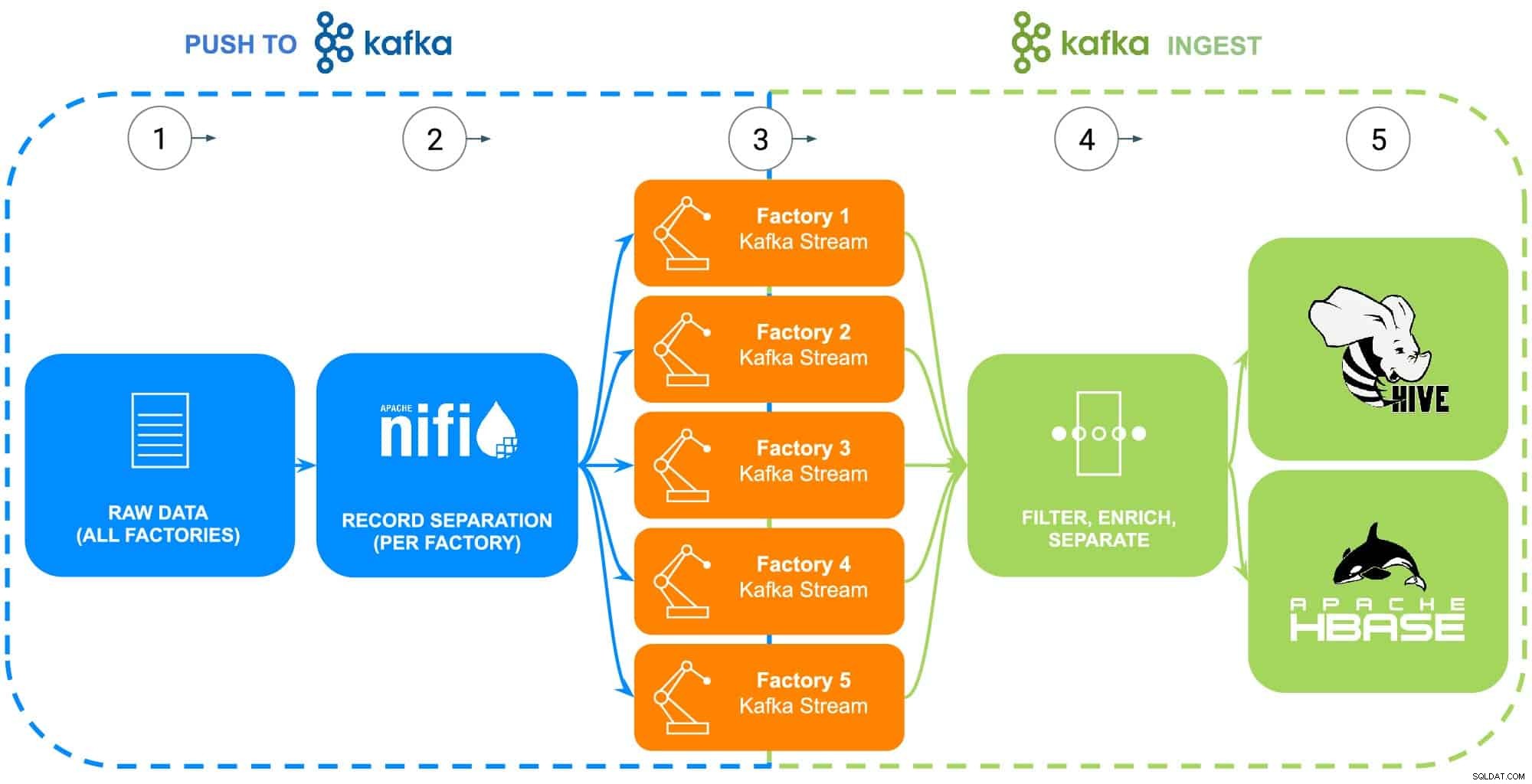

Les données de l'opération de fabrication d'ECC englobent une multitude de sources :robots industriels, réservoirs de traitement de revêtement de phosphate de corps en blanc (température, concentration ou réapprovisionnement), télématique de la chaîne d'approvisionnement ou informations sur les pièces maîtresses, etc. Pour cet exemple spécifique, la pièce brute les données de référence pour chacune des cinq usines d'ECC ont été collectées en vue d'être transmises à Apache NiFi (voir Fig 2).

ÉTAPE 2 : Configurer les sources de données pour chaque usine

La collecte de données sera illustrée à l'aide de l'expérience Data Flow de Cloudera (alimentée par Apache NiFi) pour récupérer ces données brutes et les diviser en flux d'usine individuels (gérés par Apache Kafka) pour ressembler plus précisément à un scénario réel (voir Fig 2). Pour simplifier l'exemple, les balises d'attribut de données suivantes ont été choisies pour chaque pièce générée par les usines :

- ID d'usine

- Identifiant de l'ordinateur

- Horodatage de fabrication

- Numéro de pièce

- Numéro de série

Fig 2 :Organigramme de collecte de données.

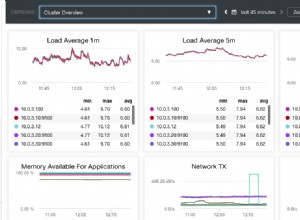

ÉTAPE 3 :Surveillez le débit de données de chaque usine

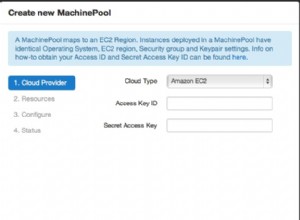

Toutes les données circulant désormais dans des flux Kafka individuels, un architecte de données surveille le débit de données de chaque usine et ajuste les ressources de calcul et de stockage nécessaires pour s'assurer que chaque usine dispose du débit requis pour envoyer des données vers la plate-forme.

ÉTAPE 4 :Capturez les données des flux Apache Kafka

Kafka capture tous les flux de données d'usine et les collecte dans des processeurs qui filtreront et enrichiront pour une utilisation dans le contrôle et l'exécution d'opérations commerciales essentielles alimentées par une base de données opérationnelle, ou en fournissant des informations sur l'entreprise via un entrepôt de données d'entreprise ou utilisées dans des analyses avancées.

ECC a récemment commencé la production d'une version améliorée de son moteur électrique qui n'est produite que dans l'usine 5, ces données seront utilisées comme illustration des prochaines étapes du cycle de vie des données

ÉTAPE 5 :Transférez les données vers les solutions de stockage

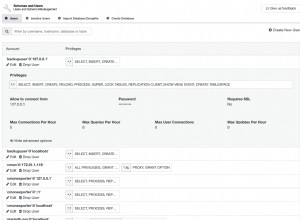

Étant donné que les ingénieurs de fabrication et de qualité d'ECC voudront surveiller de près le déploiement et l'utilisation sur le terrain de ce moteur, les données de traçabilité de fabrication spécifiques sont filtrées dans une route distincte et enregistrées dans sa propre table dans Apache Hive. Cela permettra aux ingénieurs d'exécuter ultérieurement des requêtes ad hoc dans Cloudera Data Warehouse sur les données, ainsi que de les joindre à d'autres données pertinentes dans l'entrepôt de données d'entreprise, telles que les commandes de réparation ou les commentaires des clients, afin de produire des cas d'utilisation avancés tels que la garantie, la prévision les routines de maintenance ou les apports au développement de produits.

Alternativement, si le contrôle et l'exécution d'opérations commerciales essentielles sont souhaités, l'ensemble de données complet avec l'ajout d'un horodatage traité sera envoyé dans la base de données opérationnelle Cloudera alimentée par Apache HBase. Ces données serviront de base à ECC pour exécuter sa plate-forme d'inventaire, ce qui nécessitera l'utilisation d'opérations de lecture/écriture constantes, car l'inventaire peut être à la fois ajouté et supprimé des milliers de fois par jour. Étant donné que HBase est conçu pour gérer ce type de transactions de données à grande échelle, il constitue la meilleure solution pour ce défi unique.

Conclusion

Cette illustration simple montre l'importance d'une bonne ingestion des données, car elle est fondamentale pour les informations fournies à la fois par les bases de données opérationnelles, les entrepôts de données d'entreprise ou l'analyse prédictive analytique avancée de l'apprentissage automatique. La valeur de "faire les choses correctement" inclut l'utilisation de données provenant de n'importe quelle source d'entreprise, brisant ainsi les silos de données, en utilisant toutes les données, qu'elles soient orientées vers le flux ou par lots, et la possibilité d'envoyer ces données au bon endroit pour produire les informations souhaitées en aval.

À l'aide de CDP, les ingénieurs de données ECC et d'autres utilisateurs professionnels peuvent commencer à utiliser les données collectées pour diverses tâches allant de la gestion des stocks à la prévision des pièces en passant par l'apprentissage automatique. Étant donné que Cloudera Data Flow favorise l'ingestion de données en temps réel à partir de n'importe quelle source d'entreprise, il peut être étendu et maintenu sans une connaissance approfondie des divers langages de programmation et des méthodologies de collecte de données propriétaires. Si des problèmes uniques sont rencontrés, les ingénieurs peuvent également créer leurs propres processus pour un contrôle vraiment précis.

Recherchez le prochain blog qui se penchera sur l'enrichissement des données et comment il prend en charge l'histoire du cycle de vie des données. De plus, cette histoire sera complétée par des démonstrations basées sur les données montrant le parcours des données à chaque étape du cycle de vie des données.

Plus de ressources de collecte de données

Pour voir tout cela en action, veuillez cliquer sur les liens connexes ci-dessous pour en savoir plus sur la collecte de données :

- Vidéo - Si vous souhaitez voir et entendre comment cela a été construit, regardez la vidéo sur le lien.

- Tutoriels :si vous souhaitez le faire à votre propre rythme, consultez une présentation détaillée avec des captures d'écran et des instructions ligne par ligne sur la configuration et l'exécution.

- Meetup – Si vous souhaitez parler directement avec des experts de Cloudera, veuillez rejoindre une rencontre virtuelle pour voir une présentation en direct. Il y aura du temps pour des questions/réponses directes à la fin.

- Utilisateurs :pour afficher plus de contenu technique spécifique aux utilisateurs, cliquez sur le lien.