Dans notre blog précédent, nous avons appris Hadoop HDFS en détail, maintenant dans ce blog, nous allons couvrir les fonctionnalités de HDFS. Hadoop HDFS possède des fonctionnalités telles que la tolérance aux pannes, la réplication, la fiabilité, la haute disponibilité, le stockage distribué, l'évolutivité, etc.

Toutes ces fonctionnalités de HDFS dans Hadoop seront abordées dans ce didacticiel Hadoop HDFS.

Introduction à Hadoop HDFS

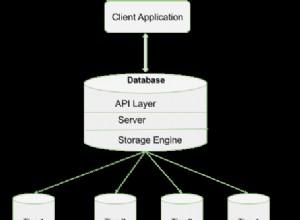

Système de fichiers distribué Hadoop (HDFS) est le système de stockage principal de Hadoop. Il stocke des fichiers très volumineux exécutés sur un cluster de matériel de base. HDFS est basé sur GFS (Google FileSystem). Il stocke les données de manière fiable même en cas de panne matérielle.

HDFS fournit également un accès à haut débit à l'application en accédant en parallèle. Selon une prévision d'ici la fin de 2017, 75 % des données disponibles sur la planète résideront dans HDFS.

6 caractéristiques importantes de HDFS

Après avoir étudié l'introduction de Hadoop HDFS, discutons maintenant des fonctionnalités les plus importantes de HDFS.

1. Tolérance aux pannes

La tolérance aux pannes dans Hadoop HDFS est la force de travail d'un système dans des conditions défavorables. Il est hautement tolérant aux pannes. Le framework Hadoop divise les données en blocs. Après cela, crée plusieurs copies de blocs sur différentes machines du cluster.

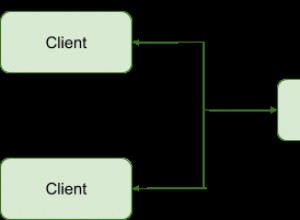

Ainsi, lorsqu'une machine du cluster tombe en panne, un client peut facilement accéder à ses données à partir de l'autre machine qui contient la même copie de blocs de données.

2. Haute disponibilité

Hadoop HDFS est un système de fichiers hautement disponible. Dans HDFS, les données sont répliquées entre les nœuds du cluster Hadoop en créant une réplique des blocs sur les autres esclaves présents dans le cluster HDFS. Ainsi, chaque fois qu'un utilisateur souhaite accéder à ces données, il peut accéder à ses données à partir des esclaves qui contiennent ses blocs.

Lors de situations défavorables comme une panne d'un nœud, un utilisateur peut facilement accéder à ses données depuis les autres nœuds. Parce que des copies de blocs en double sont présentes sur les autres nœuds du cluster HDFS.

3. Haute fiabilité

HDFS fournit un stockage de données fiable. Il peut stocker des données de l'ordre de 100s de pétaoctets. HDFS stocke les données de manière fiable sur un cluster. Il divise les données en blocs. Le framework Hadoop stocke ces blocs sur les nœuds présents dans le cluster HDFS.

HDFS stocke les données de manière fiable en créant une réplique de chaque bloc présent dans le cluster. Fournit donc une installation de tolérance aux pannes. Si le nœud du cluster contenant des données tombe en panne, un utilisateur peut facilement accéder à ces données à partir des autres nœuds.

HDFS crée par défaut 3 répliques de chaque bloc contenant des données présentes dans les nœuds. Ainsi, les données sont rapidement disponibles pour les utilisateurs. Par conséquent, l'utilisateur n'est pas confronté au problème de la perte de données. Ainsi, HDFS est extrêmement fiable.

4. Réplication

La réplication de données est une fonctionnalité unique de HDFS. La réplication résout le problème de la perte de données dans des conditions défavorables telles qu'une panne matérielle, une panne de nœuds, etc. HDFS maintient le processus de réplication à intervalles réguliers.

HDFS continue également à créer des répliques de données utilisateur sur différentes machines présentes dans le cluster. Ainsi, lorsqu'un nœud tombe en panne, l'utilisateur peut accéder aux données d'autres machines. Ainsi, il n'y a aucune possibilité de perdre des données utilisateur.

5. Évolutivité

Hadoop HDFS stocke les données sur plusieurs nœuds du cluster. Ainsi, chaque fois que les exigences augmentent, vous pouvez faire évoluer le cluster. Deux mécanismes d'évolutivité sont disponibles dans HDFS :Vertical et Évolutivité horizontale.

6. Stockage distribué

Toutes les fonctionnalités de HDFS sont réalisées via un stockage et une réplication distribués. HDFS stocke les données de manière distribuée sur les nœuds. Dans Hadoop, les données sont divisées en blocs et stockées sur les nœuds présents dans le cluster HDFS.

Après cela, HDFS crée la réplique de chaque bloc et le stocke sur d'autres nœuds. Lorsqu'une seule machine du cluster tombe en panne, nous pouvons facilement accéder à nos données à partir des autres nœuds qui contiennent sa réplique.

Conclusion

En conclusion, nous pouvons dire que HDFS est hautement tolérant aux pannes. Il stocke de manière fiable une énorme quantité de données malgré une panne matérielle. Il offre également une grande évolutivité et une haute disponibilité. Par conséquent, HDFS renforce la fonctionnalité Hadoop. Si vous trouvez une autre fonctionnalité de HDFS, veuillez nous en faire part dans la section des commentaires ci-dessous.