Dans ce didacticiel Hadoop, nous discuterons des 10 meilleures fonctionnalités de Hadoop. Si vous n'êtes pas familier avec Apache Hadoop, vous pouvez vous référer à notre Hadoop Introduction blog pour obtenir une connaissance détaillée du framework Apache Hadoop.

Dans ce blog, nous allons passer en revue les fonctionnalités les plus importantes de Big Data Hadoop telles que Hadoop Fault Tolerance, Distributed Processing in Hadoop, Scalability, Fiabilité, Haute disponibilité, économique, flexibilité, localisation des données dans Hadoop.

Présentation d'Hadoop

Hadoop est un framework logiciel open source qui prend en charge le stockage et le traitement distribués d'une énorme quantité d'ensembles de données. C'est l'outil de Big Data le plus puissant du marché en raison de ses fonctionnalités. Des fonctionnalités telles que la tolérance aux pannes, la fiabilité, la haute disponibilité, etc.

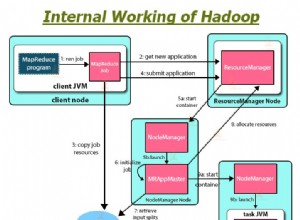

Hadoop fournit-

- HDFS – Couche de stockage la plus fiable au monde

- MapReduce – Couche de traitement distribué

- FIL – Couche de gestion des ressources

Fonctionnalités importantes de Big Data Hadoop

Il y a tellement de fonctionnalités fournies par Apache Hadoop. Discutons en détail de ces fonctionnalités de Hadoop.

un. Source ouverte

Il s'agit d'un cadre de programmation open source basé sur Java. Open source signifie qu'il est disponible gratuitement et même nous pouvons modifier son code source selon vos besoins.

b. Tolérance aux pannes

Hadoop contrôle les défauts par le processus de création de répliques. Lorsque le client stocke un fichier dans HDFS, le framework Hadoop divise le fichier en blocs. Ensuite, le client distribue les blocs de données sur différentes machines présentes dans le cluster HDFS.

Et, ensuite créer la réplique de chaque bloc se trouve sur les autres machines présentes dans le cluster. HDFS, par défaut, crée 3 copies d'un bloc sur les autres machines présentes dans le cluster.

Si une machine du cluster tombe en panne ou tombe en panne en raison de conditions défavorables. De plus, l'utilisateur peut facilement accéder à ces données à partir d'autres machines.

c. Traitement distribué

Hadoop stocke une énorme quantité de données de manière distribuée dans HDFS. Traiter les données en parallèle sur un cluster de nœuds.

d. Évolutivité

Hadoop est une plateforme open source. Cela en fait une plate-forme extrêmement évolutive. Ainsi, de nouveaux nœuds peuvent être facilement ajoutés sans aucun temps d'arrêt. Hadoop fournit une évolutivité horizontale, donc un nouveau nœud est ajouté à la volée au système. Dans Apache Hadoop, les applications s'exécutent sur plus de milliers de nœuds.

e. Fiabilité

Les données sont stockées de manière fiable sur le cluster de machines malgré les pannes de machine dues à la réplication des données. Ainsi, si l'un des nœuds tombe en panne, nous pouvons également stocker les données de manière fiable.

f. Haute disponibilité

En raison de multiples copies de données, les données sont hautement disponibles et accessibles malgré une panne matérielle. Ainsi, n'importe quelle machine tombe en panne, les données peuvent être récupérées à partir de l'autre chemin. Découvrez en détail la fonctionnalité Hadoop High Availability.

g. Économique

Hadoop n'est pas très cher car il fonctionne sur le cluster de matériel de base. Comme nous utilisons du matériel de base à faible coût, nous n'avons pas besoin de dépenser une somme énorme pour faire évoluer votre cluster Hadoop.

je. Flexibilité

Hadoop est très flexible en termes de capacité à traiter toutes sortes de données. Il traite des structurés, semi-structurés ou non structurés.

j. Facile à utiliser

Pas besoin de client pour s'occuper de l'informatique distribuée, le framework s'occupe de tout. Il est donc facile à utiliser.

k. Localité des données

Cela fait référence à la capacité de déplacer le calcul près de l'endroit où les données réelles résident sur le nœud. Au lieu de déplacer des données vers le calcul. Cela minimise la congestion du réseau et augmente le débit excessif du système. En savoir plus sur Localité des données.

Conclusion

En conclusion, nous pouvons dire que Hadoop est très tolérant aux pannes. Il stocke de manière fiable une énorme quantité de données malgré une panne matérielle. Il offre une haute évolutivité et une haute disponibilité.

Hadoop est rentable car il s'exécute sur un cluster de matériel de base. Hadoop travaille sur la localité des données car le calcul en mouvement est moins cher que le déplacement des données. Toutes ces fonctionnalités de Big data Hadoop le rendent puissant pour le traitement de Big data.