Vous pouvez également diviser les documents à la source, en combinant essentiellement chaque valeur dans un tableau d'entrées par "type" pour "in" et "out". Vous pouvez le faire simplement en utilisant $map

et $cond

pour sélectionner les champs, puis $unwind

le tableau, puis déterminez quel champ "compter" à nouveau en inspectant avec $cond

:

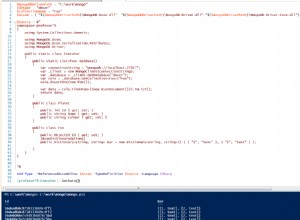

collection.aggregate([

{ "$project": {

"dates": {

"$filter": {

"input": {

"$map": {

"input": [ "in", "out" ],

"as": "type",

"in": {

"type": "$$type",

"date": {

"$cond": {

"if": { "$eq": [ "$$type", "in" ] },

"then": "$inDate",

"else": "$outDate"

}

}

}

}

},

"as": "dates",

"cond": { "$ne": [ "$$dates.date", null ] }

}

}

}},

{ "$unwind": "$dates" },

{ "$group": {

"_id": {

"year": { "$year": "$dates.date" },

"month": { "$month": "$dates.date" },

"day": { "$dayOfMonth": "$dates.date" }

},

"countIn": {

"$sum": {

"$cond": {

"if": { "$eq": [ "$dates.type", "in" ] },

"then": 1,

"else": 0

}

}

},

"countOut": {

"$sum": {

"$cond": {

"if": { "$eq": [ "$dates.type", "out" ] },

"then": 1,

"else": 0

}

}

}

}}

])

C'est un moyen sûr de le faire qui ne risque pas de dépasser la limite BSON, quelle que soit la taille des données que vous lui envoyez.

Personnellement, je préférerais exécuter des processus séparés et "combiner" les résultats agrégés séparément, mais cela dépendrait de l'environnement dans lequel vous exécutez, ce qui n'est pas mentionné dans la question.

Pour un exemple d'exécution "parallèle", vous pouvez structurer dans Meteor quelque part le long de ces lignes :

import { Meteor } from 'meteor/meteor';

import { Source } from '../imports/source';

import { Target } from '../imports/target';

Meteor.startup(async () => {

// code to run on server at startup

await Source.remove({});

await Target.remove({});

console.log('Removed');

Source.insert({

"_id" : "XBpNKbdGSgGfnC2MJ",

"po" : 72134185,

"machine" : 40940,

"location" : "02A01",

"inDate" : new Date("2017-07-19T06:10:13.059Z"),

"requestDate" : new Date("2017-07-19T06:17:04.901Z"),

"outDate" : new Date("2017-07-19T06:30:34Z")

});

console.log('Inserted');

await Promise.all(

["In","Out"].map( f => new Promise((resolve,reject) => {

let cursor = Source.rawCollection().aggregate([

{ "$match": { [`${f.toLowerCase()}Date`]: { "$exists": true } } },

{ "$group": {

"_id": {

"year": { "$year": `$${f.toLowerCase()}Date` },

"month": { "$month": `$${f.toLowerCase()}Date` },

"day": { "$dayOfYear": `$${f.toLowerCase()}Date` }

},

[`count${f}`]: { "$sum": 1 }

}}

]);

cursor.on('data', async (data) => {

cursor.pause();

data.date = data._id;

delete data._id;

await Target.upsert(

{ date: data.date },

{ "$set": data }

);

cursor.resume();

});

cursor.on('end', () => resolve('done'));

cursor.on('error', (err) => reject(err));

}))

);

console.log('Mapped');

let targets = await Target.find().fetch();

console.log(targets);

});

Ce qui va essentiellement sortir vers la collection cible comme cela a été mentionné dans des commentaires comme :

{

"_id" : "XdPGMkY24AcvTnKq7",

"date" : {

"year" : 2017,

"month" : 7,

"day" : 200

},

"countIn" : 1,

"countOut" : 1

}