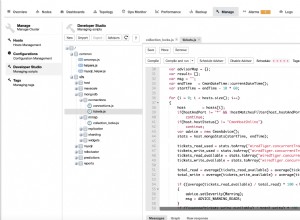

Spark ne trouve pas le com.mongodb.spark.sql.DefaultSource package, d'où le message d'erreur.

Tout, le reste a l'air bien, il suffit d'inclure le package Mongo Spark :

> $SPARK_HOME/bin/pyspark --packages org.mongodb.spark:mongo-spark-connector_2.11:2.2.0

Ou assurez-vous que le fichier jar est sur le bon chemin.

Assurez-vous de vérifier la version du package Mongo-Spark requise pour votre version de Spark : https://spark-packages.org/package/mongodb/mongo-spark