Remarque :Cet article a été initialement rédigé en 2015, mais a été mis à jour en 2019 pour refléter la nouvelle intégration entre IRI Voracity et Knime (pour Konstanz Information Miner), désormais la plate-forme d'exploration de données open source la plus puissante disponible.

L'exploration de données est la science qui consiste à extraire des connaissances à partir de données, généralement de grands ensembles de données dans lesquels des informations significatives, des tendances et d'autres informations utiles doivent être découvertes. L'exploration de données utilise l'apprentissage automatique et des méthodes statistiques pour extraire des "pépites" d'informations utiles à partir de ce qui serait autrement un ensemble de données très intimidant.

L'exploration de données couvre plusieurs disciplines informatiques et mathématiques. Il ne s'agit pas tant d'un processus unitaire que d'un terme générique désignant un ensemble d'actions. Quatre grandes tâches sont effectuées lors de l'exploration : l'analyse exploratoire des données (EDA), la modélisation descriptive, la modélisation prédictive et la découverte de modèles.

EDA utilise des méthodes de visualisation statistique conventionnelles ou des méthodes graphiques non conventionnelles pour voir si quelque chose d'intéressant peut être trouvé dans les données.

Dans la modélisation descriptive, les données sont transmises à une routine et produisent des verbes (générateurs de données) ou des adjectifs (descriptions de données) qui sont à l'origine de la formation des données. Cela inclut les méthodes qui associent les données à une distribution de probabilité, un regroupement et une modélisation des dépendances.

La modélisation prédictive utilise des méthodes de régression et de classification pour établir une norme de prédiction de futurs points de données inconnus. La régression est une analyse purement mathématique qui adapte une équation à un ensemble de données afin de prédire la valeur suivante. La modélisation prédictive peut également s'appuyer sur des règles de modèle et des tendances de relation (ou même spécifiquement identifiées de cause à effet) qui ont été découvertes à l'aide de la méthode d'analyse logique des données (LAD).

La découverte de modèles via LAD classe les nouvelles observations en fonction des classifications passées des observations et utilise des fonctions d'optimisation, combinatoires et booléennes pour améliorer la précision de l'analyse.

Pour la plupart, ces méthodes peuvent seulement indiquer quelles entrées de données sont liées, mais pas les raisons pour lesquelles ou comment elles sont liées. Il est possible d'expliquer ce qui caractérise une classe/un cluster d'un autre en trouvant ces règles ou modèles, et les sujets sont répertoriés de différentes manières en fonction des données elles-mêmes.

Les applications d'exploration de données peuvent aller du marketing d'entreprise à la médecine, de la détection des fraudes dans les banques et les assurances à l'astronomie, de la gestion des ressources humaines à l'industrie du marketing par catalogue, etc. La profession médicale l'a trouvé utile pour distinguer les attributs des personnes ayant des taux de progression de la maladie différents. Les magasins de détail utilisent désormais l'exploration de données pour mieux comprendre les habitudes de consommation des consommateurs, en notant quels articles sont achetés ensemble et leur relation, ainsi que la meilleure façon de faire de la publicité auprès de leurs clients. Et une grande partie du monde de l'entreprise s'appuie désormais sur l'exploration de données pour calculer, exécuter et justifier des décisions commerciales majeures.

Cependant, comme tout le monde le sait maintenant grâce à la récente couverture médiatique intense du scandale des enregistrements téléphoniques NSA-Verizon, l'exploration de données peut également être extrêmement controversée. Juste au cas où vous auriez vécu sous un rocher, voici un bref résumé :

Le 5 juin 2013, le quotidien britannique The Guardian a publié un rapport exclusif selon lequel des millions de dossiers de clients de Verizon, l'un des plus grands fournisseurs de télécommunications aux États-Unis, ont été collectés par la National Security Agency des États-Unis, en réponse à une ordonnance classifiée. de la Cour de surveillance du renseignement étranger des États-Unis. Les services de réseau d'entreprise de Verizon ont été contraints de remettre toutes les métadonnées de téléphonie créées par le fournisseur de services mobiles aux États-Unis et à l'étranger. En conséquence, des critiques bipartites et universelles de l'administration Obama ont alors éclaté de la part des groupes de défense des droits civiques et des médias d'information, affirmant que le président avait abusé du pouvoir exécutif. Aucune résolution de cet incident n'est en vue au moment de la rédaction de cet article. Mais cela restera sans aucun doute un excellent exemple de la façon dont l'exploration de données peut parfois être perçue sous un jour négatif, en particulier en ce qui concerne les problèmes de confidentialité et le grand public.

Lorsque vous traitez de gros volumes de données statiques ou dynamiques, il y aura très certainement des problèmes de performances de calcul et d'E/S. Avec des bases de données contenant des téraoctets et des exaoctets de données, le peignage des données peut prendre beaucoup de temps et les algorithmes de minage doivent fonctionner très efficacement. Certaines autres difficultés incluent le surajustement et les données bruitées.

Le surajustement signifie généralement qu'il n'y a pas suffisamment de bonnes données disponibles. Le modèle de données (dans ce cas, la description globale des données) devient trop complexe car comporte trop de paramètres par rapport au nombre d'observations. Cela exagère les fluctuations mineures dans les données, compromettant ainsi la fiabilité du modèle en tant que base pour faire des prédictions.

Les données bruyantes, en revanche, font référence à trop de données du mauvais type. Les données dénuées de sens, erronées, non structurées (illisibles) ou autrement corrompues augmentent les besoins de stockage et/ou nécessitent une analyse statistique pour être éliminées avant qu'elles ne puissent entraver la précision de l'exploration de données. Les bons algorithmes d'exploration de données tiennent compte des données bruyantes.

L'exploration de données est une étape unique dans un processus plus vaste connu sous le nom de découverte de connaissances dans les bases de données (KDD). KDD commence d'abord par la préparation des données :sélection, prétraitement et transformation des données, où vous déterminez ce que vous voulez étudier et le configurez de manière à pouvoir être exploité. Cela représente les données sous la forme d'une matrice m—n et avec une représentation numérique de l'élément de chaque vecteur de données. Ensuite, tu es à moi. Et enfin, vous pouvez utiliser l'ancienne caboche pour interpréter et analyser ces informations. Ensuite, si les schémas et tendances cachés ne sont toujours pas assez clairs, vous devez creuser un peu plus.

Le rôle d'IRI dans l'exploration de données et le processus KDD est de préparer et de restructurer les mégadonnées pour l'analyse grâce à de multiples fonctions de transformation de données hautes performances. Plus précisément, le package de manipulation de données IRI CoSort peut rapidement filtrer, manipuler et reformater les données afin qu'elles puissent être traitées par des algorithmes d'exploration de données tels que ces suites logicielles d'exploration de données. CoSort est également le moteur de traitement de données par défaut de la plate-forme de gestion de données IRI Voracity, conçu pour un large éventail de travaux de profilage, de préparation et de traitement des données.

Pour ceux qui travaillent avec CoSort dans l'interface graphique IRI Workbench, BIRT est un plug-in Eclipse gratuit avec des capacités de création de rapports graphiques et d'intelligence d'affaires qui incluent des fonctionnalités d'analyse et d'exploration. CoSort et BIRT Analytics utilisent tous deux l'IDE Eclipse. Avec la prise en charge du pilote de données Open Data Access (ODA) dans CoSort, l'intégration du flux de données entre les deux plug-ins est également transparente et permet des analyses de simulation plus rapides.

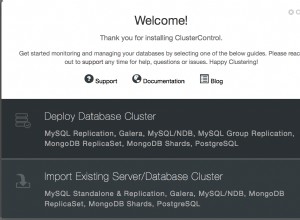

Pour ceux qui travaillent avec Voracity en 2019 et au-delà, nous suggérons d'installer le fournisseur principal de la plate-forme Knime Analytics gratuite dans IRI Workbench. Dans la même vitre Eclipse, le nœud source (fournisseur) de Voracity pour Knime peut transmettre les données brutes préparées par Voracity en mémoire aux nœuds de Knime pour les applications nécessitant une analyse statistique et prédictive, l'exploration de données et l'apprentissage machine/profond, le réseau de neurones et l'intelligence artificielle.

Les contributeurs à cet article incluent Roby Poteau et David Friedland