En utilisant Postgres 9.6.1, sqlachemy 1.1.4 et psycopg2 2.6.2 :

-

Convertissez votre structure de données en dictionnaire. De Pandas c'est

import pandas from sqlalchemy import MetaData from sqlalchemy.dialects.postgresql import insert import psycopg2 # The dictionary should include all the values including index values insrt_vals = df.to_dict(orient='records') -

Connectez-vous à la base de données via sqlalchemy . Essayez plutôt le pilote psycog2 ci-dessous et la fonction COPY native, qui contourne toute l'indexation postgres.

csv_data = os.path.realpath('test.csv') con = psycopg2.connect(database = 'db01', user = 'postgres') cur = con.cursor() cur.execute("\copy stamm_data from '%s' DELIMITER ';' csv header" % csv_data) con.commit() -

Exécuter

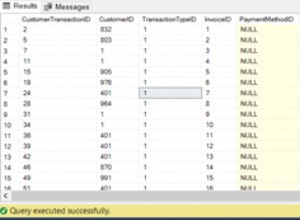

results = engine.execute(do_nothing_stmt) # Get number of rows inserted rowcount = results.rowcount

Avertissement :

Cette méthode ne fonctionne pas avec NaT est prêt à l'emploi.

Tout ensemble

tst_df = pd.DataFrame({'colA':['a','b','c','a','z', 'q'],

'colB': pd.date_range(end=datetime.datetime.now() , periods=6),

'colC' : ['a1','b2','c3','a4','z5', 'q6']})

insrt_vals = tst_df.to_dict(orient='records')

engine = sqlalchemy.create_engine("postgresql://user:example@sqldat.com/postgres")

connect = engine.connect()

meta = MetaData(bind=engine)

meta.reflect(bind=engine)

table = meta.tables['tstbl']

insrt_stmnt = insert(table).values(insrt_vals)

do_nothing_stmt = insrt_stmnt.on_conflict_do_nothing(index_elements=['colA','colB'])

results = engine.execute(do_nothing_stmt)

Au lieu des étapes 2 et 3, utilisez psycog2 pilote avec la commande de copie dans postgres est plus rapide pour les fichiers plus volumineux (approchant un concert) car il désactive toute l'indexation des tables.

csv_data = os.path.realpath('test.csv')