Le problème peut se trouver dans différentes versions d'Avro dans Hadoop de Dataproc (Avro 1.7.7) et Sqoop 1.4.7 (Avro 1.8.1).

Vous voudrez peut-être essayer de rétrograder Sqoop vers 1.4.6 qui dépend d'Avro 1.7 et d'utiliser avro-tools-1.7.7.jar lors de la soumission du travail.

Modifié :

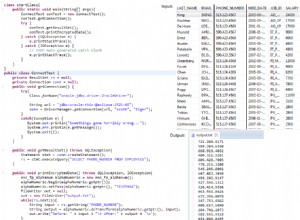

Pour résoudre le problème de chargement de classe, vous devez définir mapreduce.job.classloader=true lors de la soumission d'une tâche Dataproc :

gcloud dataproc jobs submit hadoop --cluster=<CLUSTER_NAME> \

--class=org.apache.sqoop.Sqoop \

--jars=gs://<BUCKET>/sqoop-1.4.7-hadoop260.jar \

--properties=mapreduce.job.classloader=true \

-- \

. . .