Les bases de données relationnelles ont longtemps été suffisantes pour gérer des ensembles de données petits ou moyens. Mais le rythme colossal auquel les données se développent rend l'approche traditionnelle du stockage et de la récupération des données irréalisable. Ce problème est résolu par des technologies plus récentes qui peuvent gérer le Big Data. Hadoop, Hive et Hbase sont les plates-formes populaires pour exploiter ce type de grands ensembles de données. Les bases de données NoSQL ou Not Only SQL telles que MongoDB® fournissent un mécanisme pour stocker et récupérer des données dans un modèle de cohérence perdant avec des avantages tels que :

- Mise à l'échelle horizontale

- Disponibilité accrue

- Accès plus rapide

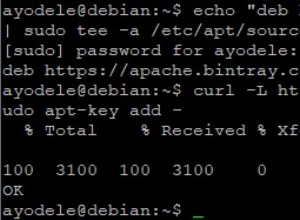

L'équipe d'ingénieurs MongoDB® a récemment mis à jour le connecteur MongoDB® pour Hadoop afin d'avoir une meilleure intégration. Cela permet aux utilisateurs de Hadoop de :

- Intégrez les données en temps réel de MongoDB® avec Hadoop pour des analyses approfondies hors ligne.

- Le connecteur expose la puissance analytique de MapReduce de Hadoop aux données d'application en direct de MongoDB®, générant de la valeur à partir du Big Data plus rapidement et plus efficacement.

- Le connecteur présente MongoDB comme un système de fichiers compatible Hadoop permettant à un travail MapReduce de lire directement à partir de MongoDB® sans le copier au préalable sur HDFS (Hadoop file System), éliminant ainsi le besoin pour déplacer des téraoctets de données sur le réseau.

- Les tâches MapReduce peuvent transmettre des requêtes en tant que filtres, évitant ainsi d'avoir à analyser des collections entières, et peuvent également tirer parti des riches capacités d'indexation de MongoDB®, notamment géospatiales, textuelles. index de recherche, de tableau, composés et creux.

- En lisant depuis MongoDB®, les résultats des tâches Hadoop peuvent également être réécrits dans MongoDB®, pour prendre en charge les processus opérationnels en temps réel et les requêtes ad hoc.

Cas d'utilisation Hadoop et MongoDB® :

Examinons une description de haut niveau de la façon dont MongoDB® et Hadoop peuvent s'intégrer dans une pile Big Data typique. Nous avons principalement :

- MongoDB® utilisé comme magasin de données en temps réel « opérationnel »

- Hadoop pour le traitement et l'analyse de données par lots hors ligne

Lisez la suite pour savoir pourquoi MongoDB est la base de données pour le traitement du Big Data et comment MongoDB® a été utilisé par des entreprises et des organisations telles que Aadhar, Shutterfly, Metlife et eBay.

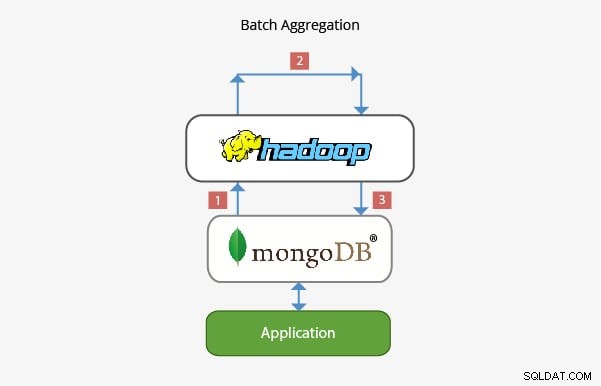

Application de MongoDB® avec Hadoop dans l'agrégation par lots :

Dans la plupart des scénarios, la fonctionnalité d'agrégation intégrée fournie par MongoDB® est suffisante pour analyser les données. Cependant, dans certains cas, une agrégation de données beaucoup plus complexe peut être nécessaire. C'est là que Hadoop peut fournir un cadre puissant pour des analyses complexes.

Dans ce scénario :

- Les données sont extraites de MongoDB® et traitées dans Hadoop via une ou plusieurs tâches MapReduce. Les données peuvent également provenir d'autres emplacements dans ces tâches MapReduce pour développer une solution multi-sources de données.

- La sortie de ces tâches MapReduce peut ensuite être réécrite dans MongoDB® pour une interrogation ultérieure et pour toute analyse ad hoc.

- Les applications construites sur MongoDB® peuvent donc utiliser les informations de l'analyse par lots pour les présenter au client final ou pour activer d'autres fonctionnalités en aval.

Application dans l'entreposage de données :

Dans une configuration de production typique, les données de l'application peuvent résider sur plusieurs magasins de données, chacun avec son propre langage de requête et sa propre fonctionnalité. Pour réduire la complexité de ces scénarios, Hadoop peut être utilisé comme entrepôt de données et servir de référentiel centralisé pour les données provenant de différentes sources.

Dans ce genre de scénario :

- Les tâches MapReduce périodiques chargent les données de MongoDB® dans Hadoop.

- Une fois que les données de MongoDB® et d'autres sources sont disponibles dans Hadoop, l'ensemble de données plus volumineux peut être interrogé.

- Les analystes de données ont désormais la possibilité d'utiliser MapReduce ou Pig pour créer des tâches qui interrogent les ensembles de données plus volumineux qui intègrent des données de MongoDB®.

L'équipe travaillant derrière MongoDB® s'est assurée qu'avec sa riche intégration avec les technologies Big Data comme Hadoop, il est capable de bien s'intégrer dans la pile Big Data et d'aider à résoudre certains problèmes architecturaux complexes lorsqu'il s'agit de stockage, de récupération, de traitement, d'agrégation et d'entreposage de données. Restez à l'écoute de notre prochain article sur les perspectives de carrière pour ceux qui adoptent Hadoop avec MongoDB®. Si vous travaillez déjà avec Hadoop ou si vous venez d'acquérir MongoDB®, consultez les cours que nous proposons pour MongoDB® ici

En savoir plus sur les concepts Hadoop. Découvrez ce cours en ligne sur le Big Data , qui a été créé par les meilleurs experts en travail industriel.