Plutôt que d'essayer de forcer la base de données à renvoyer des résultats pour des données qui n'existent pas, il est préférable de générer les données vides externes à la requête et d'y fusionner les résultats. De cette façon, vous avez vos entrées "0" là où il n'y a pas de données et autorisez la base de données à renvoyer ce qui s'y trouve.

La fusion est un processus de base consistant à créer une table de hachage de clés uniques et à remplacer simplement l'une des valeurs trouvées dans les résultats d'agrégation dans cette table de hachage. En JavaScript, un objet de base convient bien car toutes les clés sont uniques.

Je préfère également renvoyer une Date objet à partir des résultats d'agrégation en utilisant les calculs de date pour manipuler et "arrondir" la date à l'intervalle requis plutôt que d'utiliser les opérateurs d'agrégation de date. Vous pouvez manipuler les dates en utilisant $subtract

pour transformer la valeur en une représentation d'horodatage numérique en soustrayant d'une autre date avec la valeur de date d'époque, et le $mod

pour obtenir le reste et arrondir la date à l'intervalle requis.

En revanche, en utilisant $add

avec un objet de date d'époque similaire transformera une valeur entière en une date BSON. Et bien sûr, il est beaucoup plus efficace de traiter directement le $group

plutôt que d'utiliser un $project

car vous pouvez simplement traiter les dates modifiées directement dans le groupement _id valeur de toute façon.

À titre d'exemple de shell :

var sample = 30,

Days = 30,

OneDay = ( 1000 * 60 * 60 * 24 ),

now = Date.now(),

Today = now - ( now % OneDay ) ,

nDaysAgo = Today - ( OneDay * Days ),

startDate = new Date( nDaysAgo ),

endDate = new Date( Today + OneDay ),

store = {};

var thisDay = new Date( nDaysAgo );

while ( thisDay < endDate ) {

store[thisDay] = 0;

thisDay = new Date( thisDay.valueOf() + OneDay );

}

db.datejunk.aggregate([

{ "$match": { "when": { "$gte": startDate } }},

{ "$group": {

"_id": {

"$add": [

{ "$subtract": [

{ "$subtract": [ "$when", new Date(0) ] },

{ "$mod": [

{ "$subtract": [ "$when", new Date(0) ] },

OneDay

]}

]},

new Date(0)

]

},

"count": { "$sum": 1 }

}}

]).forEach(function(result){

store[result._id] = result.count;

});

Object.keys(store).forEach(function(k) {

printjson({ "date": k, "count": store[k] })

});

Qui renverra tous les jours de l'intervalle, y compris 0 valeurs où aucune donnée n'existe, comme :

{ "date" : "Tue Sep 22 2015 10:00:00 GMT+1000 (AEST)", "count" : 0 }

{ "date" : "Wed Sep 23 2015 10:00:00 GMT+1000 (AEST)", "count" : 1 }

{ "date" : "Thu Sep 24 2015 10:00:00 GMT+1000 (AEST)", "count" : 0 }

{ "date" : "Fri Sep 25 2015 10:00:00 GMT+1000 (AEST)", "count" : 1 }

{ "date" : "Sat Sep 26 2015 10:00:00 GMT+1000 (AEST)", "count" : 1 }

{ "date" : "Sun Sep 27 2015 10:00:00 GMT+1000 (AEST)", "count" : 0 }

{ "date" : "Mon Sep 28 2015 10:00:00 GMT+1000 (AEST)", "count" : 1 }

{ "date" : "Tue Sep 29 2015 10:00:00 GMT+1000 (AEST)", "count" : 1 }

{ "date" : "Wed Sep 30 2015 10:00:00 GMT+1000 (AEST)", "count" : 0 }

{ "date" : "Thu Oct 01 2015 10:00:00 GMT+1000 (AEST)", "count" : 1 }

{ "date" : "Fri Oct 02 2015 10:00:00 GMT+1000 (AEST)", "count" : 2 }

{ "date" : "Sat Oct 03 2015 10:00:00 GMT+1000 (AEST)", "count" : 0 }

{ "date" : "Sun Oct 04 2015 11:00:00 GMT+1100 (AEST)", "count" : 1 }

{ "date" : "Mon Oct 05 2015 11:00:00 GMT+1100 (AEDT)", "count" : 0 }

{ "date" : "Tue Oct 06 2015 11:00:00 GMT+1100 (AEDT)", "count" : 1 }

{ "date" : "Wed Oct 07 2015 11:00:00 GMT+1100 (AEDT)", "count" : 2 }

{ "date" : "Thu Oct 08 2015 11:00:00 GMT+1100 (AEDT)", "count" : 2 }

{ "date" : "Fri Oct 09 2015 11:00:00 GMT+1100 (AEDT)", "count" : 1 }

{ "date" : "Sat Oct 10 2015 11:00:00 GMT+1100 (AEDT)", "count" : 1 }

{ "date" : "Sun Oct 11 2015 11:00:00 GMT+1100 (AEDT)", "count" : 1 }

{ "date" : "Mon Oct 12 2015 11:00:00 GMT+1100 (AEDT)", "count" : 0 }

{ "date" : "Tue Oct 13 2015 11:00:00 GMT+1100 (AEDT)", "count" : 3 }

{ "date" : "Wed Oct 14 2015 11:00:00 GMT+1100 (AEDT)", "count" : 2 }

{ "date" : "Thu Oct 15 2015 11:00:00 GMT+1100 (AEDT)", "count" : 2 }

{ "date" : "Fri Oct 16 2015 11:00:00 GMT+1100 (AEDT)", "count" : 0 }

{ "date" : "Sat Oct 17 2015 11:00:00 GMT+1100 (AEDT)", "count" : 3 }

{ "date" : "Sun Oct 18 2015 11:00:00 GMT+1100 (AEDT)", "count" : 0 }

{ "date" : "Mon Oct 19 2015 11:00:00 GMT+1100 (AEDT)", "count" : 0 }

{ "date" : "Tue Oct 20 2015 11:00:00 GMT+1100 (AEDT)", "count" : 0 }

{ "date" : "Wed Oct 21 2015 11:00:00 GMT+1100 (AEDT)", "count" : 2 }

{ "date" : "Thu Oct 22 2015 11:00:00 GMT+1100 (AEDT)", "count" : 1 }

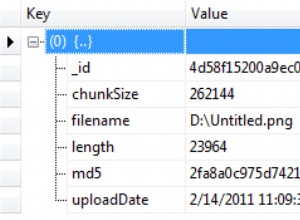

Notant que toutes les valeurs "date" sont en fait toujours des dates BSON, mais juste stringify comme ça dans la sortie de .printjson() en tant que méthode shell.

Un exemple un peu plus concis peut être montré en utilisant nodejs où vous pouvez utiliser des opérations comme async.parallel

pour traiter à la fois la construction de hachage et la requête d'agrégation en même temps, ainsi qu'un autre utilitaire utile dans nedb

qui implémente le "hachage" en utilisant des fonctions familières à l'utilisation d'une collection MongoDB. Il montre également comment cela peut évoluer pour des résultats volumineux en utilisant une véritable collection MongoDB si vous avez également modifié la gestion pour diffuser le traitement du curseur renvoyé à partir de .aggregate() :

var async = require('async'),

mongodb = require('mongodb'),

MongoClient = mongodb.MongoClient,

nedb = require('nedb'),

DataStore = new nedb();

// Setup vars

var sample = 30,

Days = 30,

OneDay = ( 1000 * 60 * 60 * 24 ),

now = Date.now(),

Today = now - ( now % OneDay ) ,

nDaysAgo = Today - ( OneDay * Days ),

startDate = new Date( nDaysAgo ),

endDate = new Date( Today + OneDay );

MongoClient.connect('mongodb://localhost/test',function(err,db) {

var coll = db.collection('datejunk');

async.series(

[

// Clear test collection

function(callback) {

coll.remove({},callback)

},

// Generate a random sample

function(callback) {

var bulk = coll.initializeUnorderedBulkOp();

while (sample--) {

bulk.insert({

"when": new Date(

Math.floor(

Math.random()*(Today-nDaysAgo+OneDay)+nDaysAgo

)

)

});

}

bulk.execute(callback);

},

// Aggregate data and dummy data

function(callback) {

console.log("generated");

async.parallel(

[

// Dummy data per day

function(callback) {

var thisDay = new Date( nDaysAgo );

async.whilst(

function() { return thisDay < endDate },

function(callback) {

DataStore.update(

{ "date": thisDay },

{ "$inc": { "count": 0 } },

{ "upsert": true },

function(err) {

thisDay = new Date( thisDay.valueOf() + OneDay );

callback(err);

}

);

},

callback

);

},

// Aggregate data in collection

function(callback) {

coll.aggregate(

[

{ "$match": { "when": { "$gte": startDate } } },

{ "$group": {

"_id": {

"$add": [

{ "$subtract": [

{ "$subtract": [ "$when", new Date(0) ] },

{ "$mod": [

{ "$subtract": [ "$when", new Date(0) ] },

OneDay

]}

]},

new Date(0)

]

},

"count": { "$sum": 1 }

}}

],

function(err,results) {

if (err) callback(err);

async.each(results,function(result,callback) {

DataStore.update(

{ "date": result._id },

{ "$inc": { "count": result.count } },

{ "upsert": true },

callback

);

},callback);

}

);

}

],

callback

);

}

],

// Return result or error

function(err) {

if (err) throw err;

DataStore.find({},{ "_id": 0 })

.sort({ "date": 1 })

.exec(function(err,results) {

if (err) throw err;

console.log(results);

db.close();

});

}

);

});

Ceci est très adapté aux données pour les tableaux et les graphiques. La procédure de base est la même pour n'importe quelle implémentation de langage, et idéalement effectuée en traitement parallèle pour de meilleures performances, donc les environnements asynchrones ou threadés vous offrent un réel bonus même si pour un petit échantillon comme celui-ci, la table de hachage de base peut être générée en mémoire très rapidement de votre environnement nécessite des opérations séquentielles.

Alors n'essayez pas de forcer la base de données à le faire. Il existe certainement des exemples de requêtes SQL qui effectuent cette "fusion" sur le serveur de base de données, mais cela n'a jamais vraiment été une bonne idée là-bas et devrait vraiment être géré avec un processus de fusion "client" similaire car il ne fait que créer une surcharge de base de données qui n'est vraiment pas t requis.

Tout cela est très efficace et pratique, et bien sûr, cela ne nécessite pas de traiter une requête d'agrégation distincte pour chaque jour de la période, ce qui ne serait pas efficace du tout.